Erros comuns em configuração de LRV & URV em Transmissores inteligentes

- Maurício Cordeiro

- 18 de jan. de 2020

- 6 min de leitura

O advento de instrumentos de campo “inteligentes” contendo microprocessadores foi um grande avanço para a instrumentação industrial. Esses dispositivos possuem capacidade de diagnóstico integrada, maior precisão (devido à compensação digital de não linearidades do sensor) e a capacidade de se comunicar digitalmente com os dispositivos host para relatar vários parâmetros.

Um diagrama de blocos simplificado de um transmissor de pressão “inteligente” se parece com isso:

É importante observar todos os ajustes deste dispositivo e como se compara à relativa simplicidade de um transmissor de pressão totalmente analógico:

Observe como os únicos ajustes de calibração disponíveis no transmissor analógico são as configurações “zero” e “span”. Este não é claramente o caso de transmissores inteligentes. Não apenas podemos definir valores de faixa inferior e superior (LRV e URV) em um transmissor inteligente, mas também é possível calibrar os circuitos de conversor analógico-digital e digital-analógico independentemente um do outro. O que isso significa para o técnico de calibração é que um procedimento de calibração completo em um transmissor inteligente requer potencialmente mais trabalho e um número maior de ajustes do que um transmissor totalmente analógico.

Um erro comum cometido entre estudantes e técnicos experientes é confundir as configurações de faixa (LRV e URV) para ajustes reais de calibração. Só porque você define digitalmente o LRV de um transmissor de pressão para 0,00 PSI e o URV para 100,00 PSI não significa necessariamente que ele será registrado com precisão em pontos dentro desse intervalo! O exemplo a seguir ilustra essa falácia.

Suponha que tenhamos um transmissor de pressão inteligente variando de 0 a 100 PSI com uma faixa de saída analógica de 4 a 20 mA, mas o sensor de pressão desse transmissor está “cansado” de anos de uso, de modo que uma pressão real aplicada de 100 PSI gere um sinal de que o analógico -to-digital interpreta como apenas 96 PSI. Supondo que tudo o mais no transmissor esteja em perfeitas condições, com calibração perfeita, o sinal de saída ainda estará com erro

Como diz o ditado, “uma corrente é tão forte quanto seu elo mais fraco”. Aqui vemos como a calibração do transmissor de pressão mais sofisticado pode ser corrompida, apesar da calibração perfeita dos circuitos conversores analógicos / digitais e das configurações de faixa perfeitas. microprocessador. O microprocessador “pensa” que a pressão aplicada é de apenas 96 PSI e responde de acordo com um sinal de saída de 19,36 mA. A única maneira de alguém saber que esse transmissor é impreciso a 100 PSI é realmente aplicar um valor conhecido de pressão de fluido de 100 PSI ao sensor e observar a resposta incorreta. A lição aqui deve ser clara: definir digitalmente os pontos LRV e URV de um instrumento inteligente não constitui uma calibração legítima do instrumento.

Por esse motivo, os instrumentos inteligentes sempre fornecem um meio para executar o que é chamado de ajuste digital nos circuitos ADC e DAC, para garantir que o microprocessador “veja” a representação correta do estímulo aplicado e para garantir que o sinal de saída do microprocessador seja convertido com precisão em uma corrente DC, respectivamente.

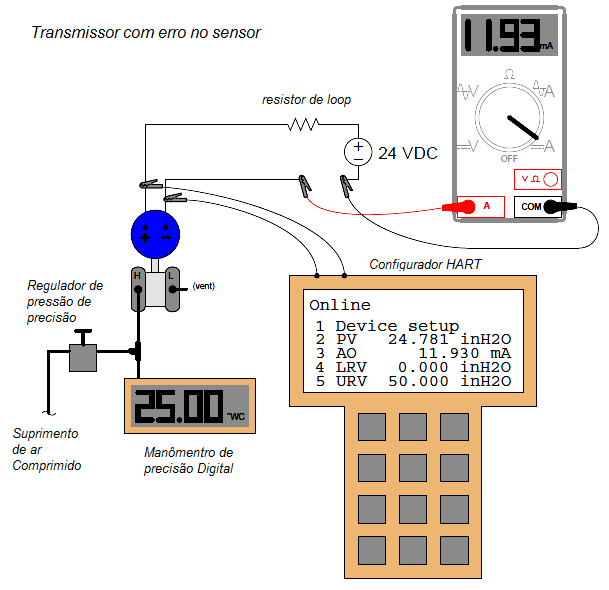

Uma maneira conveniente de testar os conversores analógicos / digitais de um transmissor digital é monitorar os registros de variável de processo (PV) e saída analógica (AO) do microprocessador enquanto compara os valores reais de entrada e saída com os padrões de calibração confiáveis. Um dispositivo comunicador HART fornece essa “visão interna” dos registros, para que possamos ver o que o microprocessador “vê”. O exemplo a seguir mostra um transmissor de pressão diferencial com um erro de calibração do sensor (analógico para digital):

Aqui, o padrão de calibração para a entrada de pressão no transmissor é um manômetro digital, registrando 25,00 polegadas de coluna de água. O multímetro digital (DMM) é nosso padrão de calibração para a saída atual e registra 11,93 miliamperes. Como esperamos uma saída de 12,00 miliamperes nessa pressão (dados os valores de faixa do transmissor de 0 a 50 polegadas W.C.), sabemos imediatamente a partir do medidor de pressão e leituras do multímetro que existe algum tipo de erro de calibração neste transmissor.

A comparação das exibições de PV e AO do comunicador HART com nossos padrões de calibração revela mais informações sobre a natureza desse erro: vemos que o valor AO (11.930 mA) é confirmada com multímetro, enquanto o valor PV (24.781 ”WC) não confirma com o manômetro digital. Isso nos diz que o erro de calibração está dentro do sensor (entrada) do transmissor e não no DAC (saída). Portanto, o procedimento de calibração correto a ser executado neste transmissor incorreto é um ajuste do sensor.

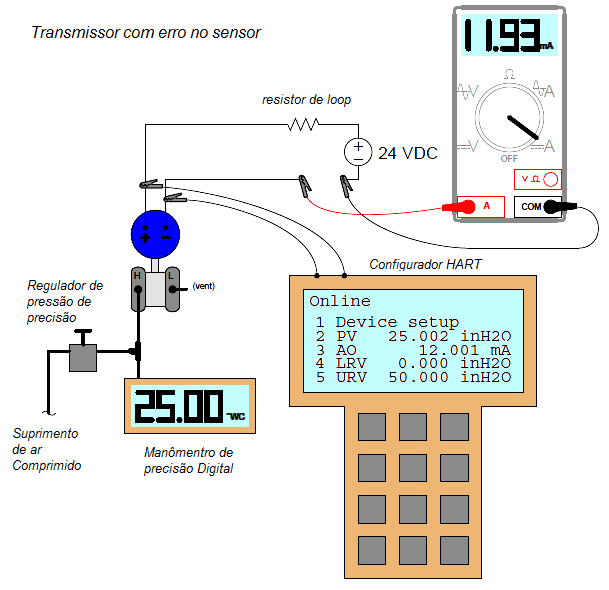

Neste próximo exemplo, vemos como seria um erro de saída (DAC) com outro transmissor de pressão diferencial submetido ao mesmo teste

Mais uma vez, o padrão de calibração para a entrada de pressão no transmissor é um medidor de pressão digital, registrando 25,00 polegadas de coluna de água. Um multímetro digital ainda serve como nosso padrão de calibração para a saída atual e registra 11,93 miliamperes. Como esperamos uma saída de 12,00 miliamperes nessa pressão (dados os valores de faixa do transmissor de 0 a 50 polegadas W.C.), sabemos imediatamente a partir do medidor de pressão e das leituras do multímetro que existe algum tipo de erro de calibração neste transmissor (exatamente como antes).

A comparação das exibições de PV e AO do comunicador HART com nossos padrões de calibração revela mais informações sobre a natureza desse erro: vemos que o valor PV (25.002 polegadas H2O) concorda com o manômetro digital enquanto o valor AO (12.001 mA) não concorde com o multímetro digital. Isso nos diz que o erro de calibração está no conversor digital-analógico (DAC) do transmissor e não no sensor (entrada). Portanto, o procedimento de calibração correto a ser executado neste transmissor incorreto é um ajuste de saída.

Observe como em ambos os cenários era absolutamente necessário interpretar os registros do microprocessador do transmissor com um comunicador HART para determinar onde o erro estava localizado. Apenas comparar as indicações de pressão e dos padrões atuais não foi suficiente para nos dizer mais do que o fato de termos algum tipo de erro de calibração dentro do transmissor. Até vermos os próprios valores de PV e AO do microprocessador, poderíamos determinar se o erro de calibração estava relacionado ao ADC (entrada), ao DAC (saída) ou talvez a ambos.

Infelizmente, tenho testemunhado técnicos tentarem usar as configurações de LRV e URV de uma maneira não muito diferente dos ajustes de zero e span de um transmissor analógico para corrigir erros como esses. Embora seja possível obter um transmissor fora de calibração para gerar valores corretos de sinal de corrente de saída em sua faixa calibrada de valores de entrada, distorcendo as configurações de LRV e URV, isso anula o objetivo de separar “trim” e “range” configurações dentro do transmissor.

Além disso, causa confusão se o sistema de controle conectado ao transmissor interroga os valores variáveis do processo digitalmente, em vez de interpretá-lo através do sinal de corrente de loop de 4-20 mA. Por fim, “calibrar” um transmissor programando-o com configurações inclinadas de LRV / URV corrompe a precisão de quaisquer funções intencionalmente não lineares, como caracterização de raiz quadrada (usada para aplicações de medição de vazão) ou tabelas de cintas (usadas para aplicações de medição de nível de líquido em vasos onde a área da seção transversal varia com a altura do líquido).

Depois que as guarnições digitais forem executadas nos conversores de entrada e saída, é claro, o técnico estará livre para redimensionar o microprocessador quantas vezes desejar, sem recalibração. Esse recurso é particularmente útil quando é desejada uma nova variação para condições especiais, como inicialização e desligamento do processo, quando determinadas variáveis do processo passam para regiões incomuns. Um técnico de instrumento pode usar um dispositivo de comunicação HART portátil para redefinir os valores de faixa LRV e URV para quaisquer novos valores desejados pela equipe de operações sem ter que verificar novamente a calibração aplicando estímulos físicos conhecidos ao instrumento.

Desde que as proteções ADC e DAC estejam corretas, a precisão geral do instrumento ainda será boa com a nova faixa. Com os instrumentos analógicos, a única maneira de mudar para uma faixa de medição diferente era alterar os ajustes de zero e span, o que exigia a re-aplicação de estímulos físicos no dispositivo (uma recalibração completa). Aqui e aqui sozinhos, vemos onde a calibração não é necessária para um instrumento inteligente. Se a precisão geral da medição deve ser verificada, no entanto, não há substituto para uma calibração física real, e isso envolve os procedimentos de “ajuste” do ADC e do DAC para um instrumento inteligente.

Os transmissores totalmente digitais (“Fieldbus”) são semelhantes aos transmissores de saída analógica “inteligentes” em relação a ajustes distintos de compensação e alcance.

Comentários