O que é calibração? Vantagens | Desvantagens

- Maurício Cordeiro

- 8 de jan. de 2020

- 11 min de leitura

Atualizado: 17 de jan. de 2020

O QUE É CALIBRAÇÃO?

Existem tantas definições de calibração quanto métodos. De acordo com o dicionário de automação, sistemas e instrumentação da ISA, a palavra calibração é definida como "um teste durante o qual os valores conhecidos de mensurando são aplicados ao transdutor e as leituras de saída correspondentes são registradas sob condições especificadas". A definição inclui a capacidade de ajustar zere o instrumento e defina o intervalo desejado. Uma interpretação da definição diria que uma calibração é uma comparação de equipamento de medição com um instrumento padrão de maior precisão para detectar, correlacionar, ajustar, retificar e documentar a precisão do instrumento que está sendo comparado.

Normalmente, a calibração de um instrumento é verificada em vários pontos ao longo da faixa de calibração do instrumento. A faixa de calibração é definida como “a região entre os limites dentro dos quais uma quantidade é medida, recebida ou transmitida, expressa pela indicação dos valores inferior e superior da faixa”. Os limites são definidos pelos valores zero e span.

O valor zero é a extremidade inferior do intervalo. Span é definido como a diferença algébrica entre os valores de faixa superior e inferior. A faixa de calibração pode diferir da faixa do instrumento, que se refere à capacidade do instrumento. Por exemplo, um transmissor de pressão eletrônico pode ter uma faixa de instrumentos na placa de identificação de 0 a 750 libras por polegada quadrada, bitola (psig) e saída de 4 a 20 miliamperes (mA). No entanto, o engenheiro determinou que o instrumento será calibrado para 0 a 300 psig = 4 a 20 mA.

Portanto, a faixa de calibração seria especificada como: 0 a 300 psig = 4 a 20 mA.

Neste exemplo, o valor de entrada zero é 0 psig e o valor de saída zero é 4 mA. O intervalo de entrada é de 300 psig é 20 mA.

Considerando uma faixa (intervalo de valos 16 mA)

Termos diferentes podem ser usados em sua instalação. Apenas tome cuidado para não confundir a faixa que o instrumento é capaz com a faixa para a qual o instrumento foi calibrado.

QUAIS SÃO AS CARACTERÍSTICAS DE UMA CALIBRAÇÃO?

Tolerância de calibração: Toda calibração deve ser realizada com uma tolerância especificada. Os termos tolerância e precisão são frequentemente usados incorretamente. No dicionário de automação, sistemas e instrumentação da ISA, as definições para cada uma são as seguintes:

Precisão: a proporção do erro para a saída em escala completa ou a proporção do erro para a saída, expressa em extensão percentual ou leitura percentual, respectivamente.

Tolerância: desvio permitido de um valor especificado; pode ser expresso em unidades de medida, porcentagem de amplitude ou porcentagem de leitura.

Como você pode ver nas definições, existem diferenças sutis entre os termos. Recomenda-se que a tolerância especificada nas unidades de medida seja usada para os requisitos de calibração executados em sua instalação. Ao especificar um valor real, os erros causados pelo cálculo de porcentagens de amplitude ou leitura são eliminados. Além disso, as tolerâncias devem ser especificadas nas unidades medidas para a calibração.

Por exemplo, você está designado para executar a calibração do

transmissor de pressão de 0 a 300 psig mencionado anteriormente com uma tolerância de calibração especificada de ± 2 psig. A tolerância de saída seria:

2 psig

÷ 300 psig

× 16 mA

—————————-

0.1067 mA

A tolerância calculada é arredondada para 0,10 mA, porque

arredondar para 0,11 mA excederia a tolerância calculada. Recomenda-se que as tolerâncias de ± 2 psig e ± 0,10 mA apareçam na folha de dados de calibração se as indicações remotas e o sinal de saída em miliamperes forem registrados.

Observe que a precisão especificada pelo fabricante para este instrumento pode ser 0,25% da escala completa (FS). As tolerâncias de calibração não devem ser atribuídas com base apenas nas especificações do fabricante. As tolerâncias de calibração devem ser determinadas a partir de uma combinação de fatores. Esses fatores incluem:

• Requisitos do processo

• Capacidade dos equipamentos de teste disponíveis

• Consistência com instrumentos semelhantes em suas instalações

• Tolerância especificada pelo fabricante

Exemplo: O processo requer ± 5 ° C; o equipamento de teste disponível é capaz de ± 0,25 ° C; e a precisão declarada pelo fabricante é de ± 0,25 ° C. A tolerância de calibração especificada deve estar entre o requisito do processo e a tolerância especificada pelo fabricante. Além disso, o equipamento de teste deve ser capaz da tolerância necessária. Uma tolerância de calibração de ± 1 ° C pode ser atribuída para consistência com instrumentos semelhantes e para atingir a taxa de precisão recomendada de 4: 1.

Precisão: Este termo foi usado no passado para descrever a relação entre a precisão do padrão de teste e a precisão do instrumento em teste. O termo ainda é usado por aqueles que não entendem os cálculos de incerteza (a incerteza é descrita abaixo). Uma boa regra é garantir uma taxa de precisão de 4: 1 ao executar calibrações. Isso significa que o instrumento ou padrão usado deve ser quatro vezes mais preciso que o instrumento que está sendo verificado. Portanto, o equipamento de teste (como um padrão de campo) usado para calibrar o instrumento de processo deve ser quatro vezes mais preciso que o instrumento de processo, o padrão de laboratório usado para calibrar o padrão de campo deve ser quatro vezes mais preciso que o padrão de campo e em breve.

Com a tecnologia de hoje, uma taxa de precisão de 4: 1 está se tornando mais difícil de alcançar. Por que uma proporção de 4: 1 é recomendada? Garantir uma proporção de 4: 1 minimizará o efeito da precisão do padrão na precisão geral da calibração. Se um padrão de nível superior estiver fora da tolerância por um fator de dois, por exemplo, as calibrações realizadas usando esse padrão têm menos probabilidade de serem comprometidas.

Suponha que usemos nosso exemplo anterior do equipamento de teste com uma tolerância de ± 0,25 ° C e que seja encontrado 0,5 ° C fora da tolerância durante uma calibração programada. Como levamos em consideração uma taxa de precisão de 4: 1 e atribuímos uma tolerância de calibração de ± 1 ° C ao instrumento do processo, é menos provável que nossa calibração realizada usando esse padrão esteja comprometida.

O padrão fora de tolerância ainda precisa ser investigado pela rastreabilidade reversa de todas as calibrações realizadas usando o padrão de teste. No entanto, nossa garantia é alta de que o instrumento do processo está dentro da tolerância. Se tivéssemos arbitrariamente atribuído uma tolerância de calibração de ± 0,25 ° C ao instrumento de processo ou utilizado equipamento de teste com uma tolerância de calibração de ± 1 ° C, não teríamos a garantia de que nosso instrumento de processo está dentro da tolerância de calibração. Isso nos leva à rastreabilidade.

Rastreabilidade: todas as calibrações devem ser executadas de acordo com um padrão reconhecido nacional ou internacionalmente. Por exemplo, nos Estados Unidos, o Instituto Nacional de Padrões e Tecnologia (NIST), anteriormente Bureau Nacional de Padrões (NBS), mantém os padrões reconhecidos nacionalmente. A rastreabilidade é definida pela ANSI / NCSL Z540-1-1994 (que substituiu a MIL-STD-45662A) como “a propriedade de um resultado de uma medição na qual ela pode estar relacionada a padrões apropriados, geralmente padrões nacionais ou internacionais, através de uma cadeia ininterrupta de comparações. ”Observe que isso não significa que uma loja de calibração precise ter seus padrões calibrados com um padrão primário. Isso significa que as calibrações executadas são rastreáveis ao NIST através de todos os padrões usados para calibrá-los, independentemente de quantos níveis existam entre a loja e o NIST.

A rastreabilidade é realizada garantindo que os padrões de teste que usamos sejam rotineiramente calibrados por padrões de referência de "nível superior". Normalmente, os padrões que usamos nas oficinas são enviados periodicamente para um laboratório de padrões com equipamentos de teste mais precisos. Os padrões do laboratório de calibração são verificados periodicamente quanto à calibração por padrões de “nível mais alto”, e assim sucessivamente até que eventualmente sejam testados contra os Padrões Primários mantidos pelo NIST ou outro padrão reconhecido internacionalmente.

O papel do técnico de calibração na manutenção da rastreabilidade é garantir que o padrão de teste esteja dentro do seu intervalo de calibração e que o identificador exclusivo seja registrado na folha de dados de calibração aplicável quando a calibração do instrumento é realizada. Além disso, quando os padrões de teste são calibrados, a documentação de calibração deve ser revisada quanto à precisão e para garantir que foi executada usando equipamento rastreável NIST.

Incerteza: Parâmetro, associado ao resultado de uma medição que caracteriza a dispersão dos valores que poderiam ser razoavelmente atribuídos ao mensurando. A análise de incerteza é necessária para laboratórios de calibração em conformidade com os requisitos da ISO 17025. A análise de incerteza é realizada para avaliar e identificar os fatores associados ao equipamento de calibração e ao instrumento do processo que afetam a precisão da calibração. Os técnicos de calibração devem estar cientes dos fatores básicos da análise de incertezas, como efeitos ambientais e como combinar várias precisões de equipamentos de calibração para chegar a uma única precisão de equipamento de calibração. A combinação de múltiplas precisões de equipamento de calibração ou instrumento de processo é feita calculando a raiz quadrada da soma dos quadrados, ilustrada abaixo:

POR QUE É NECESSÁRIA A CALIBRAÇÃO?

Faz sentido que a calibração seja necessária para um novo instrumento. Queremos garantir que o instrumento esteja fornecendo indicação precisa ou sinal de saída quando for instalado. Mas por que não podemos deixá-lo em paz enquanto o instrumento está funcionando corretamente e continua a fornecer a indicação que esperamos?

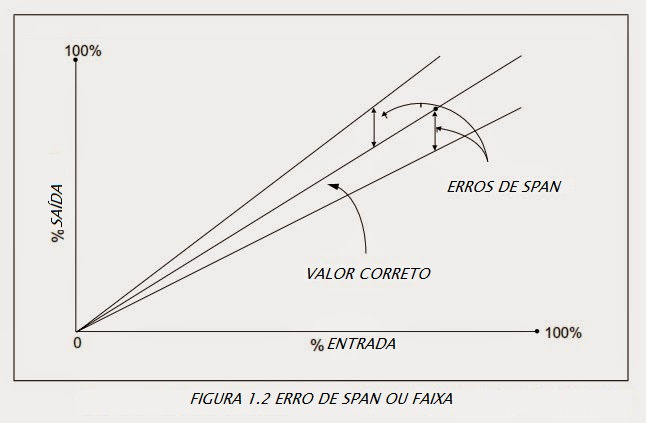

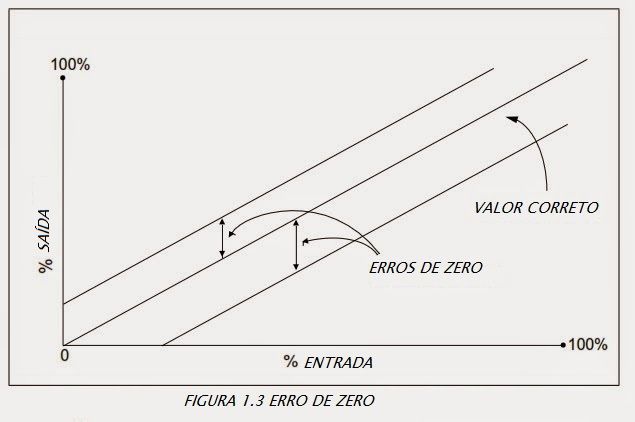

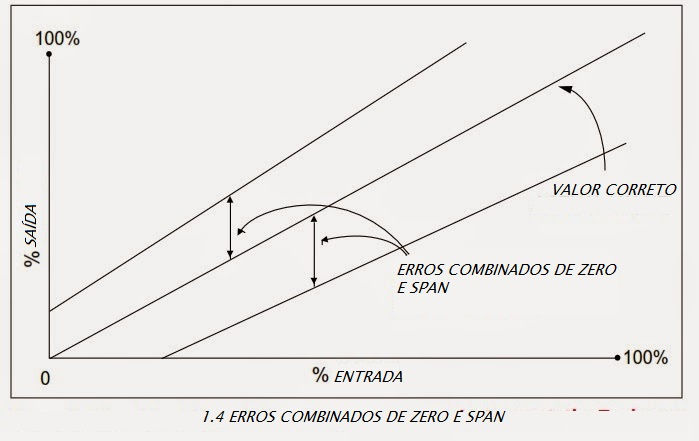

O erro do instrumento pode ocorrer devido a uma variedade de fatores: desvio, ambiente, alimentação elétrica, adição de componentes ao loop de saída, alterações no processo, etc. Como uma calibração é realizada comparando ou aplicando um sinal conhecido ao instrumento em teste, erros são detectados executando uma calibração. Um erro é a diferença algébrica entre a indicação e o valor real da variável medida. Erros típicos que ocorrem incluem:

Os erros de zero e span são corrigidos executando uma calibração. A maioria dos instrumentos é fornecida com um meio de ajustar o zero e a amplitude do instrumento, juntamente com as instruções para realizar esse ajuste. O ajuste do zero é usado para produzir um deslocamento paralelo da curva de entrada e saída. O ajuste da amplitude é usado para alterar a inclinação da curva de entrada e saída. O erro de linearização pode ser corrigido se o instrumento tiver um ajuste de linearização. Se a magnitude do erro não linear for inaceitável e não puder ser ajustada, o instrumento deverá ser substituído.

Para detectar e corrigir erros do instrumento, são realizadas calibrações periódicas. Mesmo se uma calibração periódica revelar que o instrumento é perfeito e nenhum ajuste é necessário, não teríamos sabido disso a menos que realizássemos a calibração. E mesmo que não sejam necessários ajustes para várias calibrações consecutivas, ainda executaremos a verificação de calibração na próxima data prevista de vencimento. Calibrações periódicas às tolerâncias especificadas, usando procedimentos aprovados, são um elemento importante de qualquer sistema de qualidade.

QUEM REALIZA CALIBRAÇÕES? - O TÉCNICO DO SISTEMA DE CONTROLE

Um técnico de sistema de controle (CST) é um artesão qualificado que conhece instrumentação pneumática, mecânica e elétrica. Ele compreende loops de controle de processo e sistemas de controle de processo, incluindo aqueles que são baseados em computador. Normalmente, ele ou ela recebeu treinamento em assuntos especializados, como teoria do controle, eletrônica analógica e / ou digital, microprocessadores e / ou computadores, além da operação e manutenção de linhas específicas de instrumentação de campo.

Um CST executa calibração, documentação, verificações de loop, solução de problemas e reparo ou substituição de instrumentação. Essas tarefas estão relacionadas a sistemas que medem e controlam nível, temperatura, pressão, fluxo, força, potência, posição, movimento, propriedades físicas, composição química e outras variáveis de processo.

CARACTERÍSTICAS DE UM TÉCNICO DE SISTEMA DE CONTROLE

Honestidade e integridade: Um CST deve possuir honestidade e integridade acima de tudo. A maioria dos técnicos trabalha de forma independente a maior parte do tempo. As calibrações devem ser realizadas de acordo com os procedimentos e devem ser devidamente documentadas. Além disso, o departamento de calibração pode ter falta de pessoal e os cronogramas de produção podem exigir requisitos de conclusão irrealistas. Esses fatores podem ter um impacto real no desempenho adequado e na documentação das calibrações. Lembre-se: ninguém pode tirar sua integridade; só você pode doar.

Atenção aos detalhes: As calibrações devem ser realizadas de acordo com as instruções detalhadas. Cada marca / modelo de instrumento diferente é ajustado de maneira diferente. Cada instrumento é instalado em uma configuração física e de loop diferente. Devido a essas e muitas outras diferenças, a atenção aos detalhes é muito importante. No momento em que um técnico não está prestando atenção aos detalhes, a segurança e o desempenho adequado são prejudicados.

Excelentes práticas de documentação: Em muitas instalações, a impressão de qualidade é determinada pelo conteúdo e pela aparência da documentação. Muitos técnicos reclamam que a papelada é 90% do trabalho. No mundo atual de ISO9000, cGMPs, A2LA e outros padrões de qualidade, a documentação é essencial. Se não estiver documentado, não foi feito. As folhas de dados de calibração devem ser organizadas, completas, assinadas e, se necessário, revisadas em tempo hábil. Quando ocorrem alterações, toda a documentação relacionada, como desenhos, manuais, especificações e bancos de dados também deve ser atualizada.

Compreensão dos processos: Uma coisa que diferencia os técnicos é a compreensão do processo, particularmente como os instrumentos monitoram e controlam o processo. Há uma diferença entre calibrar um componente individual e calibrar um instrumento como parte do loop de controle de processo maior. Por exemplo, saber quando um controlador pode ser colocado no manual sem afetar o processo e o que fazer enquanto o controlador estiver no manual exige uma compreensão do processo. Além disso, quando um operador diz que há um problema com sua indicação, um técnico que conhece o loop e o processo do instrumento será mais capaz de identificar a causa do problema.

Alguns conceitos básicos sobre como as calibrações devem ser realizadas precisam ser discutidos antes de prosseguirmos. Alguns desses podem ser novos conceitos não utilizados em suas instalações, mas você deve estar familiarizado com eles. Algumas dessas práticas são dependentes do setor. Embora as calibrações sejam geralmente realizadas da mesma maneira, algumas práticas diferentes foram desenvolvidas. Essas práticas são:

• Calibração de loop vs. Calibração de instrumento individual

• Calibração de bancada vs. calibração de campo

• Classificação dos instrumentos como Crítica, Não Crítica, Apenas para referência, etc.

CALIBRAÇÃO DO LOOP VS. CALIBRAÇÃO INDIVIDUAL DE INSTRUMENTOS

Uma calibração de instrumento individual é uma calibração realizada apenas em um instrumento. A entrada e a saída estão desconectadas. Uma fonte conhecida é aplicada à entrada e a saída é medida em vários pontos de dados em toda a faixa de calibração. O instrumento é ajustado, se necessário, e a calibração é verificada.

DESVANTAGENS DA CALIBRAÇÃO INDIVIDUAL

1. O loop inteiro não é verificado dentro da tolerância

2. Erros ao reconectar

3. Uso menos eficiente do tempo para fazer uma calibração para cada instrumento de loop, em oposição a uma calibração para o loop

VANTAGENS DA CALIBRAÇÃO INDIVIDUAL

1. O instrumento correto será ajustado

2. Mais compatível com calibradores multifuncionais

Por que devemos calibrar?

A calibração é necessária para:

Testando um novo instrumento

Testando um instrumento após ter sido reparado ou modificado

Teste periódico de instrumentos

Testando após o uso específico ter decorrido Antes e / ou após uma medição crítica

Quando as observações não são precisas ou os indicadores do instrumento não correspondem à saída de um instrumento substituto

Após eventos como:

Um instrumento sofreu um choque, vibração ou exposição a condições adversas, o que pode colocá-lo fora de calibração ou danificá-lo.

Mudanças climáticas repentinas

Risco envolvido na não calibração de um instrumento

Procedimento de segurança: No caso de instrumentos que envolvam produtos perecíveis, como alimentos ou termômetros com área de natureza sensível, instrumentos não calibrados podem causar riscos potenciais à segurança.

Desperdício: Se o instrumento não estiver perfeitamente calibrado, poderá levar ao desperdício potencial de recursos e tempo consumido nas operações, resultando em um aumento geral nas despesas.

Qualidade defeituosa ou questionável: Se o instrumento for calibrado incorretamente, aumentam as chances de qualidade defeituosa ou questionável dos produtos acabados. A calibração ajuda a manter a qualidade da produção em diferentes estágios, comprometida se surgir alguma discrepância.

Multas ou litígios: os clientes que sofreram danos podem devolver o produto contra um reembolso total, o que ainda está bom; mas se eles forem para litígios devido a danos, você poderá arcar com custos sérios em termos de reputação e pagamentos de restituição.

Maior tempo de inatividade: a baixa qualidade dos produtos acabados é o primeiro indicador de deterioração do seu equipamento. Programas regulares de calibração identificam sinais de alerta com antecedência, permitindo que você tome medidas antes que qualquer dano adicional seja causado.

A calibração de instrumentos é o requisito de manutenção mais básico, um procedimento estabelecido que toda empresa que utiliza máquinas ou instrumentos deve realizar periodicamente conforme especificado em seus requisitos de máquinas ou instrumentos.

Comentários